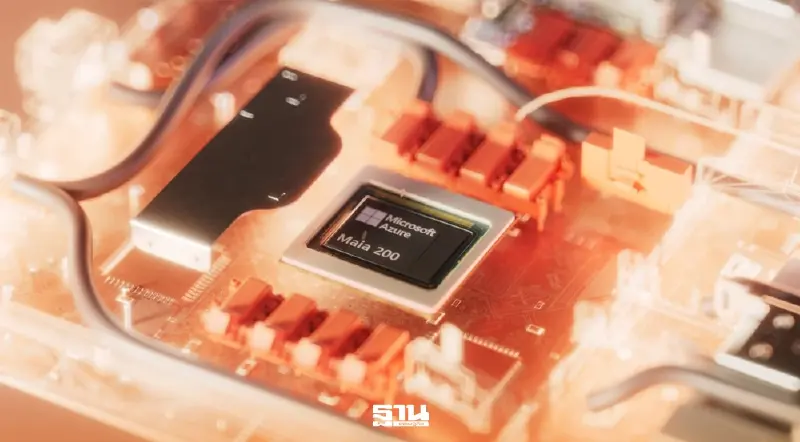

ไมโครซอฟท์ เปิดตัว Maia 200 ชิป AI เจนใหม่ยกระดับคลาวด์ Azure

ไมโครซอฟท์เปิดตัว “Maia 200” ชิป AI อินเฟอเรนซ์เจเนอเรชันใหม่ ยกระดับประสิทธิภาพพร้อมลดต้นทุนการประมวลผล พร้อมเสริมแกร่งโครงสร้างพื้นฐานคลาวด์ Azure ให้สามารถทำงานได้อย่างมีประสิทธิภาพและคุ้มค่ายิ่งขึ้น

KEY

POINTS

- ไมโครซอฟท์เปิดตัว "Maia 200" ชิป AI รุ่นใหม่ที่ออกแบบมาเพื่อเร่งการประมวลผล AI Inference โดยเฉพาะ เพื่อเสริมความแข็งแกร่งให้โครงสร้างพื้นฐานคลาวด์ Azure

- ชิปดังกล่าวผลิตด้วยเทคโนโลยี 3 นาโนเมตร มีประสิทธิภาพสูงในการรันโมเดล AI ที่ซับซ้อน ช่วยเพิ่มประสิทธิภาพและลดต้นทุนการประมวลผลได้อย่างมีนัยสำคัญ

- ปัจจุบัน Maia 200 ได้เริ่มใช้งานแล้วในบริการของไมโครซอฟท์ เช่น Microsoft 365 Copilot และมีแผนจะเปิดให้ลูกค้าทั่วไปใช้งานในอนาคต

ไมโครซอฟท์เดินหน้าสร้างมาตรฐานใหม่ให้กับอุตสาหกรรมพร้อมยกระดับโครงสร้างพื้นฐาน AI เปิดตัว “Maia 200” ชิปเร่งการประมวลผล AI สำหรับงานอินเฟอเรนซ์เจเนอเรชันล่าสุด ออกแบบมาเพื่อเพิ่มขีดความสามารถของ AI อินเฟอเรนซ์ขนาดใหญ่ ด้วยประสิทธิภาพเหนือชั้นและต้นทุนในการประมวลผลที่ลดลง Maia 200 มอบสมรรถนะสูงในการรันโมเดล AI ที่ซับซ้อนได้อย่างรวดเร็ว พร้อมเสริมแกร่งโครงสร้างพื้นฐานคลาวด์ Azure ของไมโครซอฟท์ให้สามารถทำงานได้อย่างมีประสิทธิภาพและคุ้มค่ายิ่งขึ้น

Maia 200 ผลิตด้วยกระบวนการ TSMC 3 นาโนเมตร ประกอบด้วยทรานซิสเตอร์กว่า 1 แสนล้านตัว ตอบโจทย์งาน AI ขนาดใหญ่โดยเฉพาะ ด้วยความสามารถในการประมวลผล 4-bit (FP4) ได้มากกว่า 10 PetaFLOPS และ 8-bit (FP8) ที่ประมาณ 5 PetaFLOPS ทำให้สามารถรันโมเดล AI ที่ซับซ้อนได้อย่างรวดเร็วและมีศักยภาพรองรับโมเดลในอนาคต โดยออกแบบระบบหน่วยความจำใหม่ทั้งหมดเพื่อแก้ปัญหาคอขวดด้านการส่งข้อมูล ด้วยระบบหน่วยความจำ HBM3e ขนาด 216GB ที่ความเร็ว 7 TB/s, on-chip SRAM ขนาด 272MB และ Data Movement Engine ที่ช่วยให้โมเดลขนาดใหญ่สามารถรับส่งข้อมูลได้อย่างต่อเนื่อง รวดเร็ว และใช้ทรัพยากรได้อย่างคุ้มค่า

นอกจากนี้ ประสิทธิภาพด้านราคาต่อหน่วย (perf/$) ยังดีกว่าระบบเดิมถึง 30% ทำให้ Maia 200 เป็นระบบอินเฟอเรนซ์ ประสิทธิภาพสูงที่สุดที่ไมโครซอฟท์เคยนำมาใช้งาน

นอกจากนี้ Maia 200 รองรับแบนด์วิดท์ Dedicated Scale Up ถึง 1.4 TB/s สามารถขยายการทำงานในคลัสเตอร์ขนาดใหญ่ได้ถึง 6,144 ตัว มอบประสิทธิภาพที่ปรับขนาดได้สำหรับคลัสเตอร์อินเฟอเรนซ์ ที่มีความหนาแน่นสูง ช่วยลดการใช้พลังงานและต้นทุนรวมในการเป็นเจ้าของ (TCO) สำหรับโครงสร้างพื้นฐาน Azure ทั่วโลกของไมโครซอฟท์ พร้อมที่จะบูรณาการเข้ากับ Azure Control Plane เพื่อการรักษาความปลอดภัย การตรวจสอบ และการจัดการที่ดีที่สุดในระดับชิปและระดับแร็ค

ปัจจุบัน ไมโครซอฟท์ได้เริ่มใช้งาน Maia 200 ในโครงสร้างพื้นฐานคลาวด์ทั่วโลกของบริษัท นำร่องโดยทีม Microsoft Superintelligence ที่นำไปใช้สร้างข้อมูลสังเคราะห์และการเรียนรู้แบบเสริมกำลัง เพื่อปรับปรุงโมเดลภายในองค์กร ที่สำคัญMaia 200 จะถูกใช้ขับเคลื่อนปริมาณงาน AI ใน Microsoft Foundry และ Microsoft 365 Copilot ซึ่งเป็นส่วนหนึ่งของโครงสร้างพื้นฐาน AI ของไมโครซอฟท์ และจะเปิดให้ลูกค้าใช้งานได้อย่างครอบคลุมยิ่งขึ้นในอนาคต

ทั้งนี้ ไมโครซอฟท์ได้เปิดให้ลงทะเบียนทดลองใช้ Maia SDK สำหรับนักพัฒนา นักวิชาการ และผู้ร่วมโครงการโอเพนซอร์ส เพื่อช่วยให้สามารถปรับแต่งและปรับปรุงโมเดลและปริมาณงานได้อย่างมีประสิทธิภาพ ควบคู่ไปกับการส่งเสริมการพัฒนา AI โดย Maia SDK ประกอบด้วย Triton Compiler, PyTorch, และ Maia Simulator ผู้สนใจสามารถลงทะเบียนเพื่อทดลองใช้ Maia SDK ได้ที่เว็บไซต์ทางการของไมโครซอฟท์